не согласен. ну вот взять хотя бы серийный TurtleBot.

http://www.willowgarage.com/sites/defau ... w-800w.png

http://www.willowgarage.com/turtlebot он самостоятельно катается (правда по ровному полу. у меня все кривые и огород).

что мешает поставить сверху пушку и научить стрелять в котиков?

уже считаю нужную сумму на железо.

Добавлено спустя 7 минут 53 секунды:

вот у человека есть подобный робот и ровные полы и любопытный кот.

ему бы мой водомет и "охотник" готов!

хм. видать мне придется многократно увеличить финансирование...

roboforum.ru

Технический форум по робототехнике.

Охотник

Re: Охотник

Последний раз редактировалось Nesenin 27 апр 2012, 14:11, всего редактировалось 1 раз.

Re: Охотник

Да ладно?! Да ну не! Не может быть!

Охотник? Его уже сделали, причем таким путем , о котором я лишь мечтал!

Да на x86

Да с использованием Kinect

Да в среде которую я использую - LabView

хм хм а еще тут

paintball gun, Wiimote, Neato LiDAR, National Instruments Robotics Starter Kit (DaNI) and Sparkfun Razor 9D.

не не не. я такой набор финансово не потяну

Охотник? Его уже сделали, причем таким путем , о котором я лишь мечтал!

Да на x86

Да с использованием Kinect

Да в среде которую я использую - LabView

хм хм а еще тут

paintball gun, Wiimote, Neato LiDAR, National Instruments Robotics Starter Kit (DaNI) and Sparkfun Razor 9D.

не не не. я такой набор финансово не потяну

Re: Охотник

зачем виймоут и лидар одновременно??

Re: Охотник

хотел бы я знать.

инфы по роботу в сети не нашел. Единственное что есть это профиль одного из разработчиков. По которому ясно что он крутой спец в области машинного зрения. Робот сей создан в рамках участия в конкурсе. Вполне возможно что некоторые элементы избыточны для сего проекта.

Зато в сети есть почти вся инфа по другому крутому роботу, использующего x86, Kinect, Scaning Laser Rangefinder и другие плюшки

http://www.dshinsel.com/loki-electronics/

Это домашний робот, созданный неким Dave Shinsel , который manage a software team at Intel Corporation.

Он не по жадничал и выложил исходники ПО написанное на C++ http://www.dshinsel.com/loki-turtle-software-overview/

Особо стоит заметить что предыдущий его робот это Turtle.

Ага он вдоволь наигрался с этой системой.

Тот факт, что для loki он счел наличие в качестве сенсоров лишь Kinect не достаточным, говорит о многом.

Предполагаю эти лазерные сканеры основа для быстрого и точного построения круговой диаграмы препятствий.

В случае с Armed Robot в ПО четко видно как строится карта препятствий и рассчитывается маршрут движения по данным с LIDAR'а. Для Loki ситуация та же.

И тут сравнивая с Turtle разница в скорости передвижений огромна. Фактически Turtle вынужден постоянно останавливаться для построения карты с нового угла обзора.

Получается что и для Armed Robot и для Loki применение Kinect находит в другом.

Примечательно что в Armed Robot, Kinect закреплен с возможностью вращения на оси по горизонтали.

Я предполагаю, что тут он нужен для обнаружения целей и не ровных преград. Ага прямые стены лабиринта это подходит для LIDAR'а работающего в 1 плоскости, но что делать на реальной обстановке, скажем в огороде?

Выход есть! Надо их качать туда сюда по вертикали, а еще лучше несколько таких штук сразу.

Все как в crusher

И тут самое время взглянуть на цену Hokuyo URG-04LX-UG01 Scanning Laser Rangefinder (тот что в Loki).

Вернемся к Kinect...

В Loki он закреплен на оси с возможностью вращения по вертикали. Тут, как мне кажется, он используется по назначению. ПО использует SDK Microsof и дает какие-то данные о действиях человека. Ну и еще данные о пространстве.

В принципе Kinect классная штука! И что примечательно, никакие Linux/ROS и программирование на C(и т.п.) мне особо изучать не потребуется. Есть уже куча инструментов под LabVIEW в открытом доступе.

Да, есть инструменты для получения изображения расстояний, построений карты, захвата данных о человеке.

Добрые люди на http://www.ni.com/code/robotics все это выкладывают.

Короче надо брать!

Версия Kinect для Xbox 360 стоит за бугром около 100$ + пересылка 45$

Проще найти тут б\у. Благо желающих избавится от надоевшей игрушки хватает. За 4т можно найти.

А есть еще новый Kinect for Windows. Он имеет расширенную зону действия (в ближнюю зону). Что может быть очень полезным для моих стесненных пространств. Вариант расширения зоны с помощью линз для 1 версии, судя по отзывам, убог. + тут лицензия на коммерческое использование и, наверно меньше траблов в работе с SDK.

Цена на амазон 240$. В России его начнут продавать к концу июня. см http://mscnews.ru/5842-k-koncu-iyunya-v ... ndows.html

Может у кого есть соображения на счет, что лучше купить для робота?

PS. Autonomous Robot с LabVIEW с Kinect и LIDAR ? "Тысячи их!"(с) http://youtu.be/901vWdGb2Ps

инфы по роботу в сети не нашел. Единственное что есть это профиль одного из разработчиков. По которому ясно что он крутой спец в области машинного зрения. Робот сей создан в рамках участия в конкурсе. Вполне возможно что некоторые элементы избыточны для сего проекта.

Зато в сети есть почти вся инфа по другому крутому роботу, использующего x86, Kinect, Scaning Laser Rangefinder и другие плюшки

http://www.dshinsel.com/loki-electronics/

Это домашний робот, созданный неким Dave Shinsel , который manage a software team at Intel Corporation.

Он не по жадничал и выложил исходники ПО написанное на C++ http://www.dshinsel.com/loki-turtle-software-overview/

Особо стоит заметить что предыдущий его робот это Turtle.

Ага он вдоволь наигрался с этой системой.

Тот факт, что для loki он счел наличие в качестве сенсоров лишь Kinect не достаточным, говорит о многом.

Предполагаю эти лазерные сканеры основа для быстрого и точного построения круговой диаграмы препятствий.

В случае с Armed Robot в ПО четко видно как строится карта препятствий и рассчитывается маршрут движения по данным с LIDAR'а. Для Loki ситуация та же.

И тут сравнивая с Turtle разница в скорости передвижений огромна. Фактически Turtle вынужден постоянно останавливаться для построения карты с нового угла обзора.

Получается что и для Armed Robot и для Loki применение Kinect находит в другом.

Примечательно что в Armed Robot, Kinect закреплен с возможностью вращения на оси по горизонтали.

Я предполагаю, что тут он нужен для обнаружения целей и не ровных преград. Ага прямые стены лабиринта это подходит для LIDAR'а работающего в 1 плоскости, но что делать на реальной обстановке, скажем в огороде?

Выход есть! Надо их качать туда сюда по вертикали, а еще лучше несколько таких штук сразу.

Все как в crusher

И тут самое время взглянуть на цену Hokuyo URG-04LX-UG01 Scanning Laser Rangefinder (тот что в Loki).

Вернемся к Kinect...

В Loki он закреплен на оси с возможностью вращения по вертикали. Тут, как мне кажется, он используется по назначению. ПО использует SDK Microsof и дает какие-то данные о действиях человека. Ну и еще данные о пространстве.

В принципе Kinect классная штука! И что примечательно, никакие Linux/ROS и программирование на C(и т.п.) мне особо изучать не потребуется. Есть уже куча инструментов под LabVIEW в открытом доступе.

Да, есть инструменты для получения изображения расстояний, построений карты, захвата данных о человеке.

Добрые люди на http://www.ni.com/code/robotics все это выкладывают.

Короче надо брать!

Версия Kinect для Xbox 360 стоит за бугром около 100$ + пересылка 45$

Проще найти тут б\у. Благо желающих избавится от надоевшей игрушки хватает. За 4т можно найти.

А есть еще новый Kinect for Windows. Он имеет расширенную зону действия (в ближнюю зону). Что может быть очень полезным для моих стесненных пространств. Вариант расширения зоны с помощью линз для 1 версии, судя по отзывам, убог. + тут лицензия на коммерческое использование и, наверно меньше траблов в работе с SDK.

Цена на амазон 240$. В России его начнут продавать к концу июня. см http://mscnews.ru/5842-k-koncu-iyunya-v ... ndows.html

Может у кого есть соображения на счет, что лучше купить для робота?

PS. Autonomous Robot с LabVIEW с Kinect и LIDAR ? "Тысячи их!"(с) http://youtu.be/901vWdGb2Ps

Re: Охотник

имхо, виндовый вариант. но за лицензию, если она вам не нужна придётся переплатить.

Re: Охотник

По поводу Wiimote+LIDAR

взгляните на эту Mapping System

тут тоже должны звучать фанфары.

3х осевой акселерометр из Wiimote где только не используют в качестве IMU.

И уж первым делом подключают к ПК.

В данном ролике использовано готовое ПО под ROS, но уверен под LabView тоже давно все готово и где-нибудь валяется.

У кого-нибудь осталось желание после просмотра видео выдумывать систему автономной навигации\построения карты?

У меня машина с такой скоростью не ездит как этот мужик коридоры оббегает.

В итоге получается, что все лежит готовое под linux\ROS и даже под windows\labview.

Остается только купить железо. Можно как дешевое крупносерийное Wiimote, Kinect. Дрова, софт для работы, инструкции по доработке все есть, лежит, ждет. А можно и более дорогое как LIDAR и пр., тоже есть в открытом доступе наработки. А железо уже даже в буржуйских магазинах робототехники продается.

хе. тут становится актуальной тема "догоним и перегоним". догнать возможно только влившись в эти потоки linux\ROS, windows\labview (еще может чего есть хз).

Добавлено спустя 3 часа 50 минут 24 секунды:

собственно построение карты с помощью Kinect в LabVIEW с использованием IMU и без https://decibel.ni.com/content/docs/DOC-17771.

По видео понятно что IMU позволяет делать это шустрее (раз этак в 3) и точнее . Впрочем использование LIDAR с IMU превосходит по скорости Kinect с IMU на порядок.

в примере используется IMU за 1900$...эм в то время как Wiimote <16$

и да в Wii Motion Plus есть еще и гироскопы. собственно скрещивание Wiimote с LabView https://decibel.ni.com/content/docs/DOC-1353

хм хм. что ж, это достаточно бюджетный способ сделать автономную машину.

взгляните на эту Mapping System

тут тоже должны звучать фанфары.

3х осевой акселерометр из Wiimote где только не используют в качестве IMU.

И уж первым делом подключают к ПК.

В данном ролике использовано готовое ПО под ROS, но уверен под LabView тоже давно все готово и где-нибудь валяется.

У кого-нибудь осталось желание после просмотра видео выдумывать систему автономной навигации\построения карты?

У меня машина с такой скоростью не ездит как этот мужик коридоры оббегает.

В итоге получается, что все лежит готовое под linux\ROS и даже под windows\labview.

Остается только купить железо. Можно как дешевое крупносерийное Wiimote, Kinect. Дрова, софт для работы, инструкции по доработке все есть, лежит, ждет. А можно и более дорогое как LIDAR и пр., тоже есть в открытом доступе наработки. А железо уже даже в буржуйских магазинах робототехники продается.

хе. тут становится актуальной тема "догоним и перегоним". догнать возможно только влившись в эти потоки linux\ROS, windows\labview (еще может чего есть хз).

Добавлено спустя 3 часа 50 минут 24 секунды:

собственно построение карты с помощью Kinect в LabVIEW с использованием IMU и без https://decibel.ni.com/content/docs/DOC-17771.

По видео понятно что IMU позволяет делать это шустрее (раз этак в 3) и точнее . Впрочем использование LIDAR с IMU превосходит по скорости Kinect с IMU на порядок.

в примере используется IMU за 1900$...эм в то время как Wiimote <16$

и да в Wii Motion Plus есть еще и гироскопы. собственно скрещивание Wiimote с LabView https://decibel.ni.com/content/docs/DOC-1353

хм хм. что ж, это достаточно бюджетный способ сделать автономную машину.

Re: Охотник

Nesenin писал(а):У кого-нибудь осталось желание после просмотра видео выдумывать систему автономной навигации\построения карты?

У меня есть такое желание:

И никаких лидаров и кинектов не нужно

Re: Охотник

Эм. то что ваш алгорим умудряется делать с данными от 1 веб камерой, это поразительно! (все видео я видел и слежу за обновлениями). Возможно ваше ПО, если можно так выразится, куда "умнее" тех поделок что выложили в открытый доступ .Сам я не испытывал ни одного будь то открытый или платный закрытый пакет. Естественно ничего сказать не могу.

Тут дело в другом. Технические устройства LIDAR и Kinect дают свои уникальные возможности. Такие как скоростное сканирование преград с расстояниями до десятков метров (!) в случае с LIDAR. и 3D карту близлежащего пространства для Kinect (не говоря уж про готовые функции для захвата движений человека и систему микрофонов для качественного захвата звука под распознавание речи).

Фактически эти сенсоры возвращают в ПО точки преград в 2D и 3D соответственно (обычные такие массивы двумерные трехмерные с 0 и 1), без всяких суперумных алгоритмов, грузящих процессор для обработки картинки от вебкамеры.

понятно что любой роботостроитель будет счастлив их использовать. и что важно, не понадобится больших способностей для создания на основе этих данных и открытых примеров именно того что хочется.

Меня удивляет другое. Вы давно занимаетесь этой темой. Почему вам не добавить поддержку этих контроллеров? ведь одно другому не мешает.

на Loki вообще стоят и kinect и Lidar и 2 web камеры и еще уз дальномеры! см http://www.dshinsel.com

PS я тоже придерживаюсь мнения что закрытое ПО для роботостроителей не интересно.

Тут дело в другом. Технические устройства LIDAR и Kinect дают свои уникальные возможности. Такие как скоростное сканирование преград с расстояниями до десятков метров (!) в случае с LIDAR. и 3D карту близлежащего пространства для Kinect (не говоря уж про готовые функции для захвата движений человека и систему микрофонов для качественного захвата звука под распознавание речи).

Фактически эти сенсоры возвращают в ПО точки преград в 2D и 3D соответственно (обычные такие массивы двумерные трехмерные с 0 и 1), без всяких суперумных алгоритмов, грузящих процессор для обработки картинки от вебкамеры.

понятно что любой роботостроитель будет счастлив их использовать. и что важно, не понадобится больших способностей для создания на основе этих данных и открытых примеров именно того что хочется.

Меня удивляет другое. Вы давно занимаетесь этой темой. Почему вам не добавить поддержку этих контроллеров? ведь одно другому не мешает.

на Loki вообще стоят и kinect и Lidar и 2 web камеры и еще уз дальномеры! см http://www.dshinsel.com

PS я тоже придерживаюсь мнения что закрытое ПО для роботостроителей не интересно.

Re: Охотник

Nesenin писал(а):Меня удивляет другое. Вы давно занимаетесь этой темой. Почему вам не добавить поддержку этих контроллеров? ведь одно другому не мешает.

Каких таких контроллеров?

Re: Охотник

Nesenin писал(а):Меня удивляет другое. Вы давно занимаетесь этой темой. Почему вам не добавить поддержку этих контроллеров? ведь одно другому не мешает.

Просто я считаю, что в изображениях с одной единственной видеокамеры, расположенной на роботе, вполне достаточно информации для полноценной навигации. Доказательства очевидны: управляя роботом вручную, я способен объезжать препятствия, а так же провести робота из одной комнаты в другую. Раз уж я это могу сделать, значит и машину можно этому научить и это не фантастика – этот факт доказывают мои, достаточно примитивные эксперименты, и это реально уже сейчас, на имеющийся уже сегодня аппаратуре.

К чему я стремлюсь?

Моя мечта – научить машину воспринимать реальный мир с помощью зрения. Это позволит сделать навигацию робота полностью автономной в незнакомом и неподготовленном окружении (квартира, дом, улица, другая планета).

И вот чего уж точно никогда не появится в проекте «AVM Navigator», так это каких либо других вспомогательных датчиков типа лидаров или кинектов. Всё что будет использовать Навигатор – так это только изображения видеокамеры (это моя принципиальная позиция).

К тому же такой подход удешевляет стоимость конечного изделия, что является более привлекательным для пользователей.

Вот здесь, не подготовленное и незнакомое пространство, и всё что имеет робот в своём распоряжении для навигации – это всего лишь изображения с видеокамеры, причём местами достаточно плохого качества. Однако это не помешало ему добраться с моей спальной аж на кухню

Re: Охотник

=DeaD=, эм. ок. не правильно назвал. (просто в голове вертится что kinect это контролер см http://ru.wikipedia.org/wiki/Kinect в интерен магазинах ищу в соответствующем разделе) пусть будут "датчики".

EDV, тогда "догнать и перегнать" не получится. все равно что ас вождения будет на запорожце пытаться обогнать новичка на болиде F1. пока он разбирается где газ, где тормоз, вы его объедите, а дальше то что?

звучит как

думаю я не буду далек от истины, если предположу, что люди сделавшие все эти автономные машины (не только google) глядят на потуги самодельщиков со слезами на глазах и улыбкой на устах.

у меня вопрос: что такое "зрение"?

если проводить параллели с животным миром. Почему у вас только 1 "глаз" ? Где стерео?

почему только видимый диапозон? в животном мире есть представители которые "видят" тепло (змеи) электрические поля (акулы).

чем IR depth-finding camera не зрение?

почему это изображение не может быть частью системы зрения?

не может быть частью системы зрения?

я конечно не настаиваю. но все же. пока вы будите мучатся с изображением от 1 вебкамеры.

люди без "само барьеров" уже во всю будут пользоваться машинами с автопилотом.

EDV, тогда "догнать и перегнать" не получится. все равно что ас вождения будет на запорожце пытаться обогнать новичка на болиде F1. пока он разбирается где газ, где тормоз, вы его объедите, а дальше то что?

EDV писал(а):Моя мечта – научить машину воспринимать реальный мир с помощью зрения.

звучит как

думаю я не буду далек от истины, если предположу, что люди сделавшие все эти автономные машины (не только google) глядят на потуги самодельщиков со слезами на глазах и улыбкой на устах.

у меня вопрос: что такое "зрение"?

если проводить параллели с животным миром. Почему у вас только 1 "глаз" ? Где стерео?

почему только видимый диапозон? в животном мире есть представители которые "видят" тепло (змеи) электрические поля (акулы).

чем IR depth-finding camera не зрение?

почему это изображение

не может быть частью системы зрения?

не может быть частью системы зрения? я конечно не настаиваю. но все же. пока вы будите мучатся с изображением от 1 вебкамеры.

люди без "само барьеров" уже во всю будут пользоваться машинами с автопилотом.

Re: Охотник

Nesenin писал(а):EDV, тогда "догнать и перегнать" не получится.

Смотря где обгонять

у EDV'а оно распознает образы, скажем никакой лидар не даст опознавание автомобильных знаков, лиц и т.п.

у EDV'а оно распознает образы, скажем никакой лидар не даст опознавание автомобильных знаков, лиц и т.п.Re: Охотник

Nesenin писал(а):у меня вопрос: что такое "зрение"?

если проводить параллели с животным миром

Ну нету у животных лидаров и кинектов

Nesenin писал(а):Почему у вас только 1 "глаз" ? Где стерео?

Я делаю акцент на дешевизне конечного продукта, а если камеры будет две (стереозрение) то и компьютеров (или видеопроцессоров) нужно тоже два. К тому же зачем это делать, к примеру, если вы закроете один глаз, то это же не означает, что вы будете неспособны, ориентироваться в пространстве?

Nesenin писал(а):Я конечно не настаиваю. но все же. пока вы будите мучатся с изображением от 1 вебкамеры.

люди без "само барьеров" уже во всю будут пользоваться машинами с автопилотом.

Чёта я пока что не наблюдаю на улицах городов таких автомобилей, наверное, там не всё так просто, как показывают в рекламных роликах. А если бы, даже все бы уже ездили бы на машинах с лидарами, то меня бы это ну никак бы не смутило в разработке моего подхода к проблеме навигации по визуальным ориентирам

Re: Охотник

эм. вообще то LIDAR выдает расстояния до преград (которые отражают лазер).

каким путем эти данные позволят распознать изображение в видимом диапазоне на плоскости?

каждому устройство свое применение. скажем, такая штука как Стрелка-СТ http://www.spt-nn.ru/ru/indexfb37.php?p=1166533322 сделает, то что с использованием одной веб камеры не возможно, в принципе.

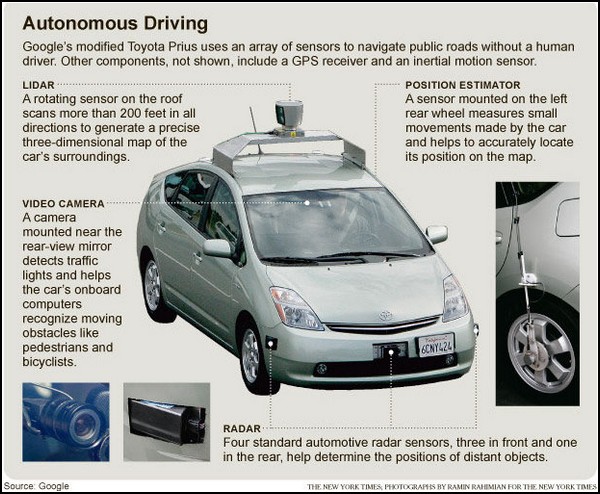

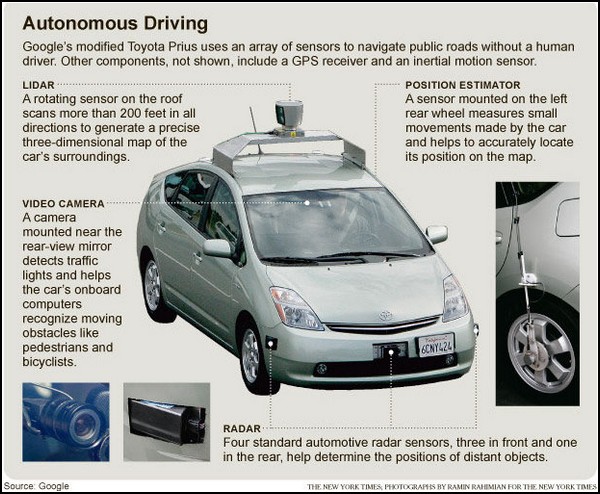

в гугло мобиле есть несколько камер, радаров, лидаров и прочего. у всего свое назначение.

Но вместе все это позволяет делать автономные машины уже сейчас.

И в случае автомобиля используемого на дорогах общего пользования, 1 камеры явно не достаточно...

Фактически. если применять кучу всяких датчиков, сенсоров можно сделать такие устройства, которые превосходят возможности человека.

банальные примеры:

тепловизор, дальномеры, оптическое увеличение, радары.

вот допустим элементарная задача: найти врага ночью в туман на дистанции несколько километров, навести орудие танка с учетом поправок на ветер и другие мешающие факторы и произвести выстрел во время движения.

каково а? это задача успешно решена.

надеюсь в контексте темы, понятно каким образом?

я хочу максимум возможного и невозможного тоже! не понимаю зачем себя ограничивать?

каким путем эти данные позволят распознать изображение в видимом диапазоне на плоскости?

каждому устройство свое применение. скажем, такая штука как Стрелка-СТ http://www.spt-nn.ru/ru/indexfb37.php?p=1166533322 сделает, то что с использованием одной веб камеры не возможно, в принципе.

в гугло мобиле есть несколько камер, радаров, лидаров и прочего. у всего свое назначение.

Но вместе все это позволяет делать автономные машины уже сейчас.

И в случае автомобиля используемого на дорогах общего пользования, 1 камеры явно не достаточно...

Фактически. если применять кучу всяких датчиков, сенсоров можно сделать такие устройства, которые превосходят возможности человека.

банальные примеры:

тепловизор, дальномеры, оптическое увеличение, радары.

вот допустим элементарная задача: найти врага ночью в туман на дистанции несколько километров, навести орудие танка с учетом поправок на ветер и другие мешающие факторы и произвести выстрел во время движения.

каково а? это задача успешно решена.

надеюсь в контексте темы, понятно каким образом?

я хочу максимум возможного и невозможного тоже! не понимаю зачем себя ограничивать?

Re: Охотник

Nesenin писал(а):каждому устройство свое применение

Швейцарский нож, ПК, МФУ, коммуникаторы и много чего другого существует в этом мире и не жужжит